Intelligenza artificiale, un passo più vicina

Si fanno sempre più consistenti gli sforzi dei produttori nel campo del deep learning e del machine learning, passi fondamentali verso una auspicabile (?) intelligenza artificiale complessa che potrebbe cambiare per sempre le nostre vite e il corso della storia. Proprio su questa strada si sta muovendo AMD che oggi lancia una nuova scheda grafica, RADEON INSTINCT che contribuirà ad aumentare notevolmente le prestazioni e l’efficienza delle implementazioni di deep learning.

Se siete interessati a questo argomento, vi consigliamo caldamente di leggere il comunicato qui sotto.

Radeon Instinct offre funzionalità di Machine Intelligence senza precedenti

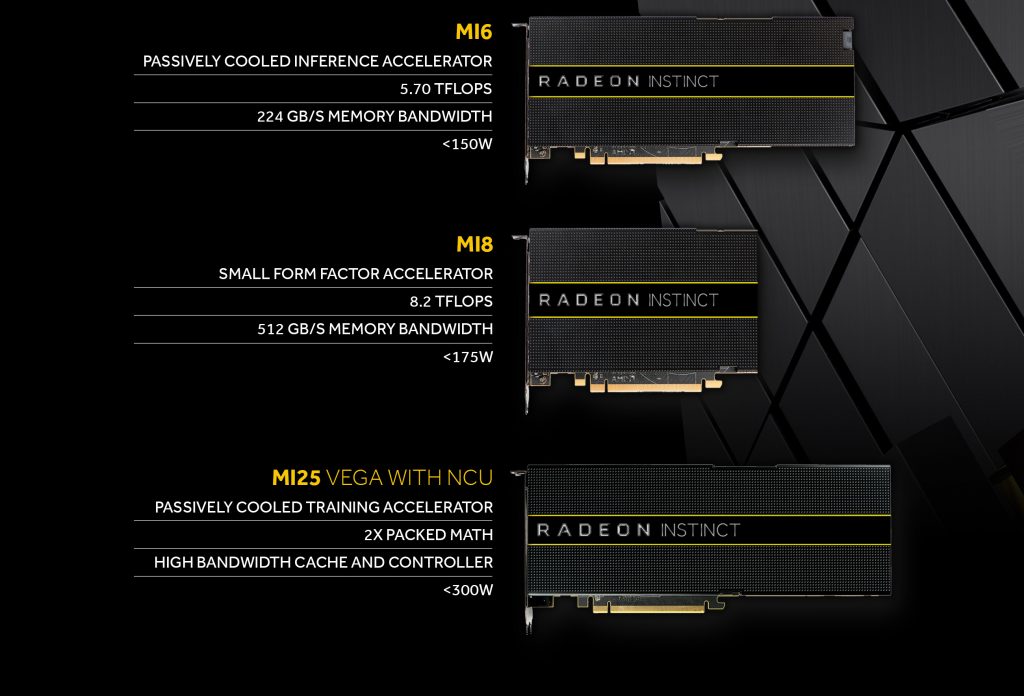

AMD entra nel nel campo del instinct computing con la nuova scheda grafica Radeon Instinct, a breve disponibile ai partner per soluzioni HPC e deep learning. Come mostrato a dicembre 2016, questa nuova linea di acceleratori server GPU – Radeon Instinct MI25, Radeon Instinct MI8 e Radeon Instinct MI6 – insieme alla open platform di AMD ROCm 1.6, contribuirà ad aumentare notevolmente le prestazioni, l’efficienza e la facilità di implementazione, velocizzando il deep learning e i training necessari per arrivare alla Machine Intelligence.

I tre acceleratori Radeon Instinct sono stati progettati per soddisfare una vasta gamma di applicazioni di machine learning, tra cui:

- Radeon Instinct™ MI25, basato sull’architettura GPU “Vega” con processi FinFET da 14 nm, sarà l’acceleratore definitivo per le applicazioni di machine intelligence su larga scala e per le soluzioni di apprendimento per i datacenter. Il modello MI25 offre prestazioni FP16 e FP32[1] superiori, utilizzando una singola scheda server GPU raffreddata passivamente con 24.6 TFLOPS di FP16 o 12.3 TFLOPS di FP32 attraverso le sue 64 unità di calcolo (4.096 processori di flusso). Con 16GB di ampiezza di banda della memoria GPU HBM2 ECC[2] e fino a 484 GB/s di memoria, il design del Radeon Instinct MI25 è ottimizzato per applicazioni massicciamente parallele con grandi set di dati per carichi di lavoro sui sistemi di Machine Intelligence e HPC- class.

- Radeon Instinct™ MI8, che sfrutta l’efficienza energetica ad alte prestazioni caratteristica dell’architettura GPU “Fiji”, unisce a un form factor HPC 8.2 TFLOPS di prestazioni massime FP16 | FP32 a meno di 175W di consumi energetici e 4 GB di RAM di tipo High-Bandwidth Memory (HBM) su un’interfaccia di memoria a 512 bit. I’MI8 si adatta alla perfezione nel campo del machine learning e alle applicazioni HPC.

- Radeon Instinct™ MI6, basato sulla famosa architettura GPU “Polaris”, è un acceleratore a raffreddamento passivo con 5.7 TFLOPS di prestazioni massime FP16 | FP32 a 150W e 16GB di memoria GDDR5 ad alta velocità su un’interfaccia di memoria a 256 bit. L’MI6 è un acceleratore versatile e ideale per applicazioni HPC e per il machine learning.

Le schede Radeon Instinct sono supportate dalle soluzioni software open source di AMD, tra cui:

· La piattaforma software ROCm 1.6, in arrivo il 29 giugno con miglioramenti delle prestazioni e con il supporto per MIOpen 1.0. Si tratta di una piattaforma completamente scalabile e open source, che offre una soluzione di calcolo potente e flessibile costituita da un driver open-source Linux® ottimizzato per il calcolo multi-GPU, che fornisce modelli di programmazione multipli, dallo strumento di conversione HIP CUDA e dal supporto per l’accelerazione GPU mediante l’Heterogeneous Computing Compiler (HCC). · MIOpen, la libreria GPU open-source accelerata è ora disponibile con la piattaforma ROCm e supporta i framework della machine intelligence, incluso il supporto previsto per Caffe, TensorFlow e Torch.

AMD consegnerà a partire da Q3 i prodotti Radeon Instinct ai suoi partner (tra cui Boxx, Colfax, Exxact Corporation, Gigabyte, Inventec e Supermicro), per aiutarli a sviluppare ulteriormente le competenze nell’ambito delle soluzioni HPC.

Per maggiori informazioni, puoi visitare Radeon.com/Instinct.

1] TFLOPS calculations: FLOPS calculations are performed by taking the engine clock from the highest DPM state and multiplying it by 64 CUs per GPU. Then, multiplying that number by 64 shader units, which exist in each CU. Then, that number is multiplied by 2 FLOPS per clock for FP32. To calculate TFLOPS for FP16, 4 FLOPS per clock were used. The FP64 TFLOPS rate is calculated using 1/16th rate.

[1] ECC support is limited to the HBM2 memory and ECC protection is not provided for internal GPU structures