Completato il prototipo di un processore Intel a 80 core: la rivoluzione alle porte.

Super Computing

All’ International Solid State Circuits Conference di San Francisco, Intel ha mostrato il primo prototipo di un processore a 80 core il cui nome è Tera Scale. Le caratteristiche costruttive di questo processore non sono particolarmente esaltanti: 275mm quadrati di superfice Die con 110 milioni di transistor non rappresentano sicuramente un primato(almeno paragonato a Penryn e ai suoi 410 milioni di transistor), tuttavia è assolutamente interessante l’idea che sta dietro al progetto. Ciascun core è “diviso” in due parti, una dedicata all’elaborazione dati, l’altra ad un router (messaging passing router)che reindirizza le informazioni elaborate agli altri core condividendole.

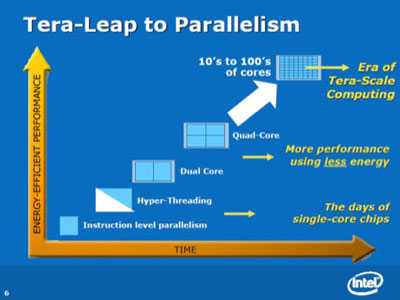

Ciascun core è dotato poi di due unita Floating point multiply-accumulator (FPMAC) 3Kbytes di memoria per istruzioni a singolo ciclo e 2 Kbytes per memorizzare dati. Il pregio di un architettura siffatta è che eleva alla massima potenza il concetto di calcolo in parallelo, ciascun core elabora soltanto un piccolissimo numero di semplici informazioni condividendole poi con gli altri core, riuscendo a raggiungere in questo modo velocità nelle future evoluzioni dell’architettura, superiori a qualsiasi altro tipo di processore “tradizionale” vista l’enorme scalabilità del progetto

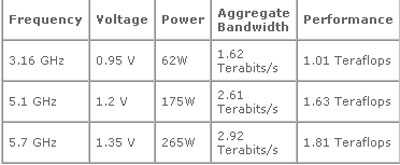

Il processore dimostrato aveva un clock di 3,13 GHz, con voltaggio da 1v ed era in grado di generare una potenza di elaborazione di 1.0 teraFLOPS con un consumo di 98W, tuttavia resta possibile utilizzare versioni più parche di consumi, 11W e 310 Giga FLOPS di potenza ad esempio, oppure con un clock più elevato, come mostrato nella tabella.

I nuovi processori non sono del tipo x86, ma utilizzano una architettura VLIW (Very Long Instruction Word) più semplice rispetto a quella x86 e più adatta al tipo di calcolo per cui questi processori sono nati.

In Intel sono convinti che questo nuovo tipo di processore possa costituire una vera e propria rivoluzione nell’ ambito del super computing permettendo di raggiungere capacità di calcolo di svariate centinaia di TeraFLOP con un numero notevolmente ridotto di processori rispetto alle attuali soluzioni, con un evidente risparmio economico ed energetico.