E’ un dato di fatto, a parità di dimensioni dello schermo, la distanza di visione influenza la percezione dei dettagli. Più vi allontanerete dallo schermo, minori saranno i dettagli dell’immagine che riuscirete a percepire. Questa considerazione andrebbe sempre tenuta a mente quando si sceglie una nuova TV: quale sarà la mia distanza di visione? e se l’interrogativo risoluzione FHD o 4K sta diventando sempre meno importante, grazie alla progressiva scomparsa dei tv con risoluzione 1920×1080 dagli scaffali dei grandi centri commerciali, presto, con l’arrivo delle TV 8K toneremo a porci la stessa domanda: meglio puntare sulla risoluzione o sulle dimensioni?

Eppure risoluzione e dimensioni non sono l’unico aspetto che conta quando si parla di qualità della visione.

Non si ci si riflette abbastanza su questo aspetto, ma a differenza del mondo dei PC, dove il più delle volte ci si trova ad una distanza ravvicinata dallo schermo, quando si gioca con una console lo si fa magari seduti sul divano o ad una distanza di almeno due metri, non avendo la necessità di utilizzare la tastiera e il mouse. A questa distanza, come mostra la tabella qui sotto (fonte Panasonic) per scorgere la differenza di dettaglio tra un’ immagine Full HD (1920×1080) ed una in 4K (3840×2160) occorrerebbe uno schermo di almeno 55” e se ci si allontana ad almeno 2,5m, una distanza molto comune se si gioca in salotto, occorrono addirittura 65” per scorgere una differenza rilevante tra un segnale Full HD ed uno UltraHD.

Se la distanza ha un ruolo fondamentale nella percezione dei dettagli, non così si può dire per la percezione dei colori.

La nostra capacità di riconoscere diverse sfumature di colore ha svolto un ruolo essenziale in termini evolutivi.

I nostri occhi percepiscono radiazioni di lunghezza d’onda fra 400 e 700 nanometri, che cromaticamente vanno dal rosso al verde al blu. Addirittura le sfumature che hanno lunghezze d’onda comprese fra i 490 e i 570, che corrispondono alle diverse tonalità di verde, sono quelle che il nostro occhio è in grado di cogliere con maggiore precisione anche a grandissima distanza.

L’origine del fenomeno è evolutiva; è infatti grazie alla nostra capacità di distinguere anche a grande distanza i colori, ed in particolare il verde, che l’uomo e prima ancora i primati hanno avuto maggiori chance di sopravvivenza, avendo la possibilità di individuare con maggior facilità un predatore o una preda tra il fogliame.

Questo esempio ci fa capire la grande importanza che ha la resa dei colori di una immagine e di quanto questa, rincorrendo il numerino della risoluzione, possa essere trascurata nella scelta di una TV o di un monitor.

- Se state cercando le migliori TV per videogiocare, date uno sguardo qui.

- Se invece cercate una TV da utilizzare come monitor, potete dare uno sguardo a questa guida.

- A questo indirizzo, invece, la nostra guida ai monitor G-sync e FreeSync.

Cos’è HDR?

High Dynamic Range (HDR) è una sigla sempre più comune quando si acquista una TV ma spesso un marketing confusionario e l’esistenza di diverse varianti e sigle come HDR10, HDR10+ , Dolby Vision e HGL complicano la vita degli acquirenti.

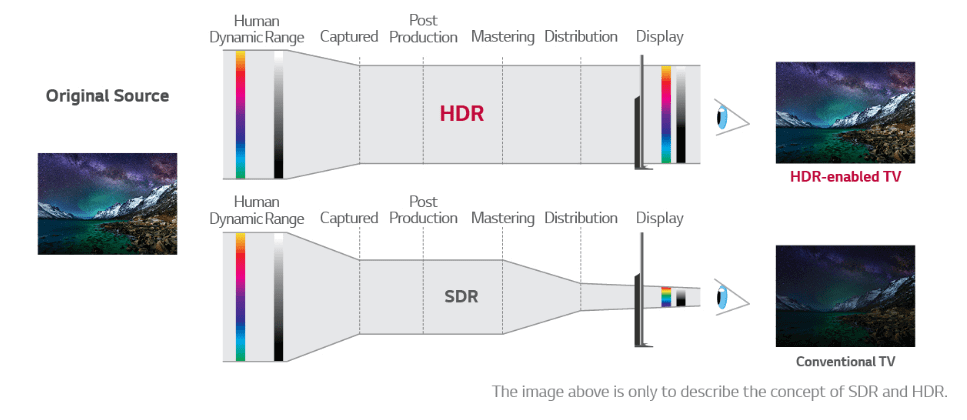

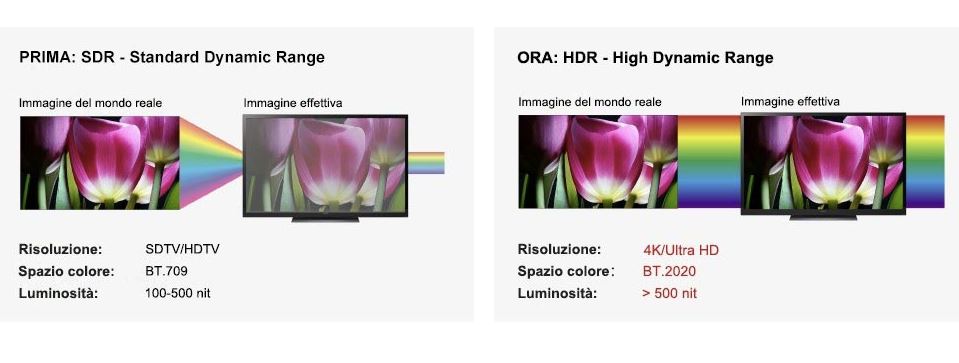

Fino a qualche tempo fa le tv e i monitor si basavano esclusivamente su una metrica del colore detta SDR. Un display Standard Dynamic Range, in sostanza, utilizza una curva EOTF convenzionale (ovvero la funzione matematica che dice quanta luminanza produrre per ciascun colore), tipicamente con 8 bit di profondità di colore. In questi casi il rapporto di contrasto è limitato a circa 1.200 a 1. Nei display SDR, la retroilluminazione è usata semplicemente per fornire luce uniforme. L’array di cristalli liquidi è l’unico responsabile della gestione del contenuto di colore. Poiché la retroilluminazione per l’intero display è controllata ad un livello, che è spesso il punto più bianco in una data immagine, il contenuto più scuro perde di dettaglio. Per evitare infatti che la parte luminosa appaia priva di dettagli la luminosità si abbassa uniformemente e la parte più scura ne paga le conseguenze (e viceversa).

Un display High Dynamic Range, o HDR, d’altra parte, usa una curva EOTF che è estesa su entrambe le estremità della gamma luminosa e tipicamente richiede un minimo di 10 bit di profondità di colore. In questo schema, è abbastanza facile ottenere rapporti di contrasto ben oltre 200.000 a 1.

Nei display HDR, inoltre, la retroilluminazione è spesso divisa in zone più piccole e controllata individualmente (local dimming). Abbinando il controllo della luminosità di queste zone ai dati dei pixel sovrapposti si estende la gamma di contrasto.

Gli schermi HDR hanno lo scopo visualizzare una gamma molto più ampia di colori e contrasto, offrendo quella che è conosciuta come High Dynamic Range (appunto HDR) i cui standard sono stati stabiliti il 27 agosto 2015 dalla Consumer Technology Association (CTA) negli Stati Uniti.

Praticamente le TV con tecnologia HDR aumentano il rapporto di contrasto e lo spazio colore, al fine di offrire immagini naturali, e più simili a quello che l’occhio umano percepisce nel mondo reale. Volendo fare un esempio, una immagine di una roccia in ombra o da un lato e illuminata dal sole, sarebbe complicatissima da gestire su uno schermo SDR, ma aumentando lo spazio colore e il livello di contrasto sarà possibile offrirne una rappresentazione veritiera sia della parte in ombra che della parte illuminata, grazie ad una maggiore gamma di colore e di contrasto.

L’HDR al momento con i pannelli 10 bit in commercio è in grado di riprodurre il 54% dei colori esistenti nel mondo reale, e nei prossimi anni si spingerà oltre con i pannelli 12 bit, arrivando fino al 76%.

Il suo arrivo ha rappresentato una svolta molto importante, paragonabile a quella epocale del passaggio all’alta definizione (dal 480i a 1080p).

HDR10 – valori costanti

Tutte le TV HDR in commercio supportano lo standard HDR10. Il suffisso 10 deriva proprio dalla necessità di utilizzare un pannello a 10 bit (o nel peggiore dei casi 8bit+metadati) per la visualizzazione di questi contenuti. HDR è uno standard open source, non richiede il pagamento di licenze, ed è quindi uno standard supportato da lettori BD, console da gioco, servizi di streaming. Sfrutta una luminosità massima fino a 4.000 nits, (anche se gli attuali prodotti sono molto lontani da questo valore), ed è in grado di riprodurre oltre un miliardo di sfumature di colore. I contenuti che supportano questo formato sono tantissimi mentre la sua applicazione avviene tramite l’inserimento di metadati statici

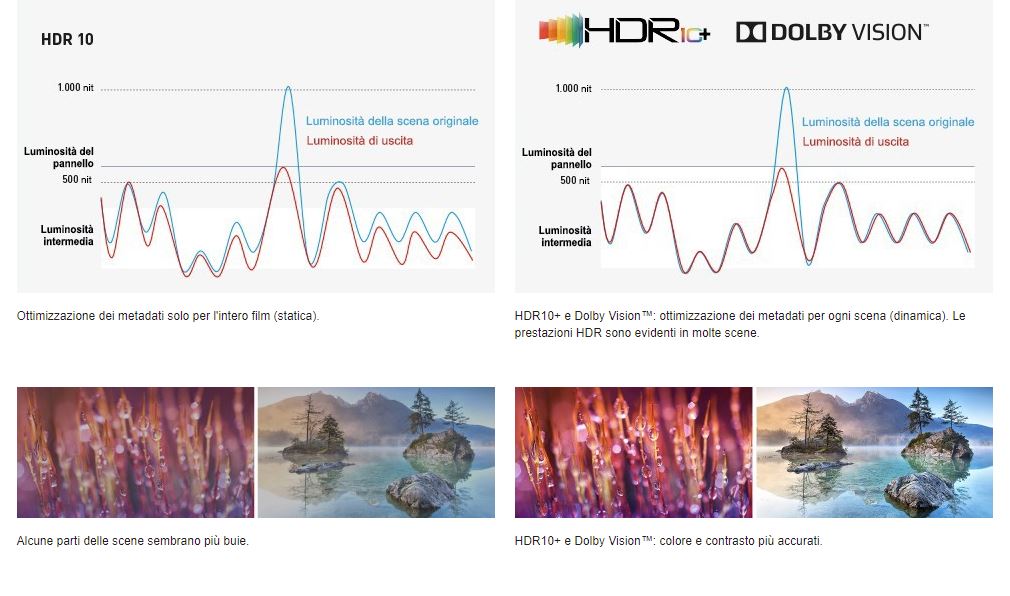

I metadata sono delle informazioni che accompagnano il video e che servono alla TV ad adattare (tone mapping) le informazioni fornite dal flusso video alle caratteristiche hardware del display. In fase di post produzione infatti, viene effettuato il grading dei colori sulla base di uno standard (BT.2020) che prevede una gamma enorme di sfumature di colore molto superiore a quanto ad oggi riproducibile anche sul più moderno dei display. Per fare in modo che questo contenuto venga riadattato alla capacità di riproduzione di ciascun display (espressa in nit, 500 nits, 600 nits, 1000nits ecc.) il tv effettua una rimappatura dei colori o se volete una compressione della gamma dinamica. Se così non fosse tutto ciò che il TV non può riprodurre perchè fuori dalla sua gamma dinamica verrebbe perso. I metadati servono proprio a questo a fornire le istruzioni per riadattare quei toni che lui non è in grado di riprodurre.

Con i metadati statici di HDR queste istruzioni rimangono stabili dall’inizio alla fine del contenuto.

Questo è un punto molto importante, in pratica con HDR10 e i metadati statici (HDR10), il TV regola il segnale per l’intero film in base alla scena con la luminosità più alta. HDR10+ e Dolby Vision, permettono al TV di regolare il senale scena per scena (per sequenza di fotogrammi) grazie a metadati dinamici. In questo modo, lo schermo associa con maggiore precisione il contenuto alle caratteristiche del pannello in uso e visualizza tutte le scene con la saturazione e la luminosità ottimali.

Dolby Vision

Dolby Vision è stata la prima risposta al problema dei metadati statici. La necessità cioè di adattare il tone mapping alle diverse scene, in modo da offrire una rappresentazione ancora più realistica della gamma dinamica. DV supporta i metadati dinamici, oltre che una profondità colore a 12bit, e pannelli con luminosità fino a 10.000 nits. La maggior parte di questi valori sono ancora teorici, in quanto non esistono pannelli a 12 bit, e non esisteranno luminosità cosi elevate (se non con l’arrivo delle tv Microled ), tuttavia l’attuale utilizzo dei metadati dinamici quando ben implementato offre un’ulteriore salto qualitativo.

Questi metadati contengono istruzioni scene per scena che possono essere utilizzate da un display compatibile per garantire che il contenuto sia riprodotto nel modo più accurato possibile. I televisori compatibili con Dolby Vision combinano le informazioni scena per scena ricevute dalla sorgente, adattando luminosità, contrasto e resa cromatica alle specifiche del display.

Se si confronta una immagine Dolby Vision con una HDR , la prima mostra più dettagli nelle aree luminose, colori più equilibrati, sfumati, e naturali in tutto lo spettro dinamico; nel 90% dei contenuti c’è anche una migliore gestione della gamma di contrasto e quindi un maggiore senso di dettaglio.

Dolby Vision tuttavia è una tecnologia proprietaria, la sua implementazione necessita il pagamento della licenza a Dolby, e proprio per questo non è facile trovare TV di fascia medio/bassa con questa tecnologia. Tuttavia molti creatori di contenuti hanno abbracciato la filosofia e lo standard Dolby e tra questi molti studi cinematografici come Lionsgate, Sony Pictures, Universal Warner Bros, Netflix (Stranger Things) e Amazon Prime Video (Jack Ryan).

HDR10+

Esattamente come il Dolby Vision già descritto, HDR10+ è un’evoluzione del formato base, nato nei laboratori Samsung per fornire una soluzione più economica al Dolby Vision. Il fine dei metadati dinamici di HDR10+ è lo stesso, variare la resa dell’HDR sequenza per sequenza, garantendo quindi l’ottimizzazione continua su luminosità, contrasto, e gamma colori

Nonostante sia stato sviluppato da Samsung l’implementazione del formato è gratuita e non richiede il pagamento di royalties e grazie al supporto di Amazon Prime video, 20th Century Fox, Panasonic e Philips la sua diffusione sta progressivamente aumentando.

HDR10+ vs. Dolby Vision

La resa visiva tra questi due formati è del tutto paragonabile, tutto dipende (come sempre) dall’implementazione dei creatori di contenuti, oggi paragonando le migliori fonti disponibili dei due formati non esiste un formato qualitativamente migliore dell’altro

La più importante differenza tra i due formati è che HDR10+ ha una profondità di colore a 10-bit, contro i 12-bit di Dolby Vision. Oggi non esistono pannelli a 12-bit tuttavia l’arrivo nel prossimo futuro di pannelli a 12-bit metterebbe Dolby Vision su un un altro piano, in quanto in grado di sfruttare una gamma dinamica semplicemente non possibile su pannelli 10bit.

HLG : L’HDR delle trasmissioni tv

Acronimo di Hybrid Log Gamma, è in pratica l’HDR applicato alle trasmissioni televisive, ed eventi LIVE, è stato realizzato dalla ricerca congiunta tra la BBC inglese e l’emittente giapponese NHK.

HLG riesce a combinare gamma dinamica standard (SDR), e alta gamma dinamica (HDR) in un singolo segnale video, questa caratteristica per le trasmissioni via cavo o satellite si rivela fondamentale, in quanto ogni utente può riprodurre il segnale, in HDR se la tv è adatta, e in SDR sulle vecchie TV, senza lasciare indietro nessuno.

Inoltre tale segnale utilizza una compressione VP-9 o HEVC che limita i dati inviati e rende possibile l’utilizzo delle attuali tecnologie DTT.

Non tutte le TV HDR anche se si tratta di un formato ibrido, riconoscono il formato HLG. A partire dal 2018 tutte le tv hanno cominciato a supportare in massa il nuovo formato, ma per quelle antecedenti a tale data tutto dipende dal produttore e dalla sua volontò di aggiornare via software dispositivi oramai considerati obsoleti.

Le migliori TV HDR10+ e Dolby Vision.

Ora che abbiamo visto cosa sono queste tecnologie, vediamo quali sono le migliori tv per rapporto qualità prezzo in grado di sfruttarle.

Miglior televisore Dolby Vision economico

Hisense ULED H9G

Quando si parla di tv dal miglior rapporto qualità prezzo esistono ben pochi altri marchi in grado di offrire la stessa qualità visiva di Hisense ad un prezzo paragonabile. L’Hisense Uled H9G, presentato al CES 2020 e disponibile nel nostro paese da aprile (ma molto complicato da trovare) è un QLED con controllo locale della luminosità a 180 zone, e picco di luminosità di 1000 cd/m2. Il filtro Quantum Dot permette il supporto WCG richiesto dall’HDR, in questo caso HDR10 e Dolby Vision.

Il pannello è basato su tecnologia VA ha una scansione nativa a 120 Hz, mentre la sezione audio supporta il Dolby Atmos. Le elaborazioni sono affidate al processore Hi-View Engine AI. Il sistema operativo è Android TV con supporto Google Assistant. Non è il tv perfetto per il gaming perchè non supporta il VRR (variable refresh rate) ma ha ottimi tempi di risposta e un bassissimo input lag

Miglior televisore per accuratezza dei colori

Sony XH95

Sony XH95 è uno dei tv a TV LED di punta di Sony dell’anno scorso e come tale ha un’eccellente accuratezza del colore out-of-the-box, quindi puoi goderti i contenuti HDR non appena tirato fuori dalla scatola, ma a prezzi decisamente più accessibili rispetto all’attuale top di gamma.

Ha una delle più ampie gamme di colori per un tv di questa fascia di prezzo e una copertura eccezionale dello spazio colore DCI P3 più comunemente usato. Ha anche un’eccellente luminosità di picco in HDR, il che lo rende perfetto per la riproduzione di contenuti HDR. Con il suo pannello VA, ha neri profondi e ha una funzione di local dimming full-array . Ancora una volta non è la migliore opzione per i videogiocatori. Pur avendo una frequenza di aggiornamento di 120Hz, non supporta alcuna tecnologia VRR, e il suo input lag è troppo alto per il gioco competitivo. Tuttavia, ha un grande tempo di risposta, quindi i contenuti in rapido non sono un problema. Ha integrato Android TV. Sceglietelo se siete fanatici della precisione e dell’accuratezza dei colori.

Il miglior tv HDR10+/Dolby Vision

LG OLED 65CX

Quando si parla di migliori tv dal punto di vista della qualità visiva, accuretezza colore, funzionalità gaming, un solo nome fa brillare gli occhi agli appassionati LG OLED CX. La serie CX di LG è eccellente televisore sotto tutti i punti di vist a e grazie alla tecnologia OLED, non c’è alcun blooming intorno agli oggetti luminosi.

Visualizza una gamma di colori estremamente ampia con una copertura quasi perfetta dello spazio colore DCI P3 utilizzato nella maggior parte dei contenuti. Ha anche una copertura decente del più ampio spazio colore Rec. 2020, e out-of-the-box, ha una grande precisione del colore. È una buona scelta per l’uso in stanze luminose in quanto ha un’eccezionale gestione dei riflessi. E’ ideale nei giochi HDR, grazie ad un input lag davvero basso, un tempo di risposta quasi istantaneo e al supporto per la tecnologia VRR (variable refresh rate) per ridurre lo screen tearing. Gli unici svantaggi sono la possibilità di burn in (comunque molto remota per un utilizzo normale da tv per giochi e film) e la luminosità non cosi’ alta come i tv LED . Questo come abbiamo visto può incidere quando si tratta di filmati HDRche richiedono una alta luminanza dei pannelli. In ogni caso , tutte le altre qualità compensano ampiamente questo piccolo svantaggio (stiamo parlando comunque di una luminosità di punta di circa 850nits)